देश में इन दिनों AI का खूब इस्तेमाल किया जा रहा है। जिसमें क्राइम की दुनिया में लोग AI का इस्तेमाल करके फर्जी डीपफेक वीडियो बना रहे हैं। ऐसे में अब सवाल आता है कि इस डीपफेक से खुद के कैसे बचाया जाए। आइए हम आपको कुछ तरीकों के बारे में बताने वाले हैं।

हाइलाइट्स

- देशभर में साइबर क्राइम के लिए इस्तेमाल हो रहा डीपफेक

- AI की मदद से क्राइम को अंजाम दे रहे क्रिमनल

- इन तरीकों से खुद को डीपफेक से बचा सकते हैं

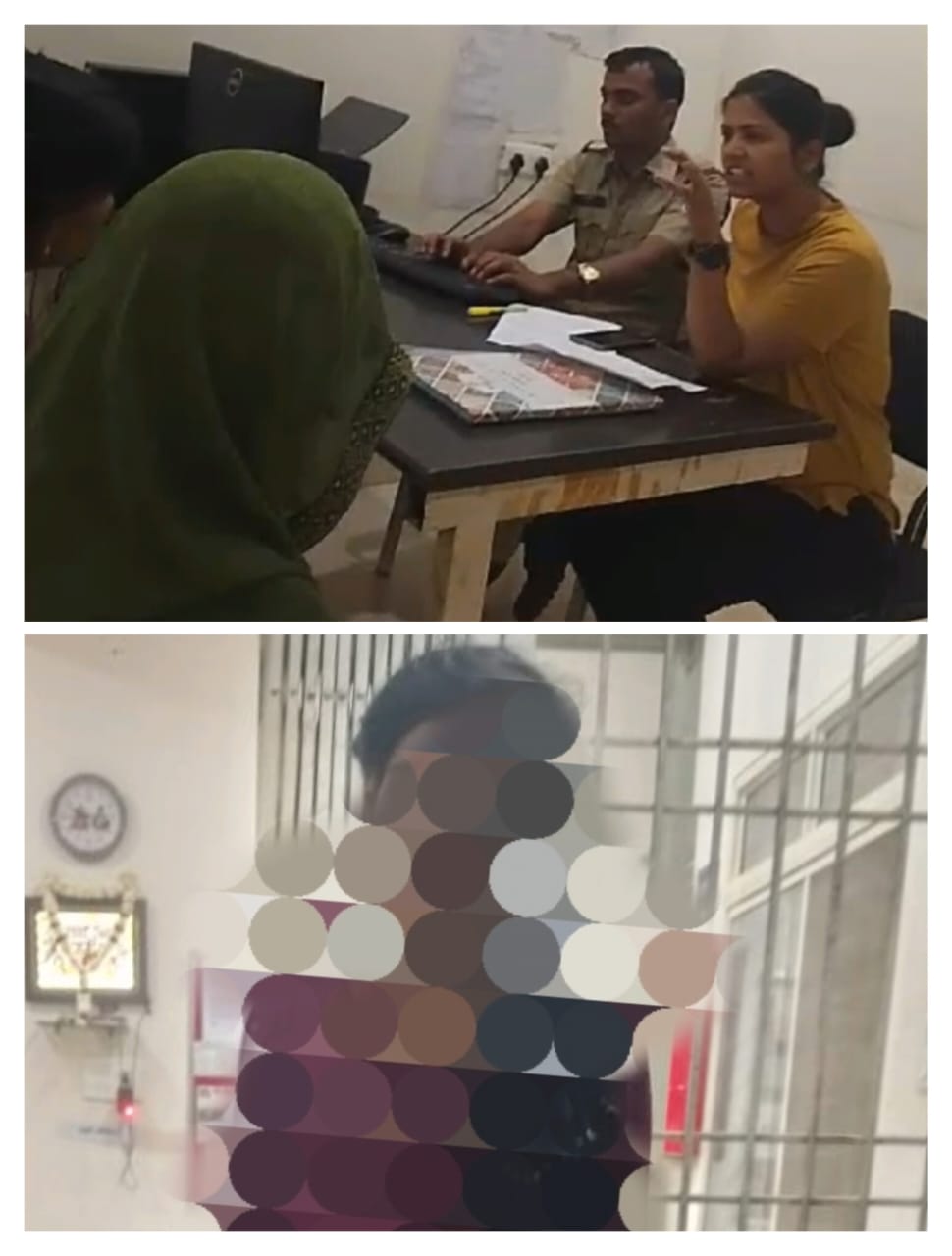

डीपफेक वीडियो से बचने का तरीका नई दिल्ली: साइबर अपराधों में इन दिनों ‘डीपफेक’ चर्चा में है। AI यानी आर्टिफिशल इंटेलिजेंस की मदद से कभी आपकी या आपके करीबी की हूबहू आवाज, फोटो, विडियो के जरिए मनचाहे अपराध को अंजाम दिया जा सकता है। पिछले महीने एक्टर रश्मिका मंदाना के डीपफेक विडियो से जानी-मानी सेलिब्रिटी तक दंग रह गईं। हाल ही में यूपी पुलिस के सीनियर आईपीएस अफसर प्रेम प्रकाश का एक्सटॉर्शन के लिए फेक विडियो वायरल हुआ। AI का जितना दायरा दुनियाभर में फैल रहा है, उससे ज्यादा चुनौतियां और उससे जुड़े खतरे बढ़ रहे हैं। जाने-माने साइबर एक्सपर्ट डॉ रक्षित टंडन और दिल्ली पुलिस के IFSO डीसीपी हेमंत तिवारी ने सभी संभावित खतरों और बचाव के तरीकों को साझा किया।

डीपफेक क्या है?

डॉ रक्षित टंडन के मुताबिक, आर्टिफिशल इंटेलिजेंस (AI) के टूल के जरिए 3डी एनीमेशन सॉफ्टवेयर फोटो, विडियो, ऑडियो को थोड़े से इनपुट के साथ हूबहू क्रिएट कर सकता है। AI को समझना पहले आसान नहीं था। लेकिन अब AI के टूल्स इस्तेमाल करने में मदद के लिए कई ऐप, यूट्यूब विडियो, लिंक और वेबसाइट्स आसानी से उपलब्ध हैं। उनके सॉफ्टवेयर काम करते हैं। जब AI लोगों की हूबहू डुप्लिकेट बना सकता है तो जिनका मकसद है दूसरों को धोखा देना या बदनाम करना तो यह यह जोखिम अलर्ट करने वाला है।

कैसे काम करता है?

डीपफेक के लिए फेस-स्वेपिंग की जाती है। इसके लिए दो नेटवर्क काम करते हैं। एक एनकोडर और दूसरा डिकोडर। एनकोडर यानी डेटा सिग्नल को दूसरे सिग्नल में कन्वर्ट करता है। यह ऐसा डिवाइस है, जो मैकेनिकल मोशन को डिजिटल या एनालॉग सिग्नल में फीडबैक देता है। डिकोडर असली नकली की पहचान कर उसमें कन्वर्ट करता है। इससे मिलता-जुलता चेहरा बनाया जा सकता है। प्रीपैकेज्ड फेस-स्वैपिंग प्रोग्राम, वॉयस क्लोनिंग ऐप जैसी इमेज जेनरेट तकनीकी हर दिन तेजी से बढ़ रही हैं।

सावधानी के टिप्स

- सोशल मीडिया पर पर्सनल फोटो विडियो शेयर करने से बचें।

- सेटिंग में जाकर अपने जानकारों को ही फोटो और विडियो के लिए एलाऊ करें।

- पासवर्ड हमेशा से स्ट्रॉन्ग रखें, उससे फोटो और विडियो को सुरक्षित रखा जा सकता है।

पांच साल तक की सजा का प्रावधान

डॉ रक्षित टंडन के मुताबिक, बीते दिनों भारत में ‘डीपफेक’ और AI की मदद से साइबर अपराध के कई मामले सामने आने पर दिल्ली समेत राज्यों की पुलिस और सेंट्रल इन्फॉर्मेशन टेक्नोलॉजी का मंत्रालय हैरान है। डीपफेक और AI उनके लिए बड़ा खतरा है, जो सोशल मीडिया पर न सिर्फ एक्टिव हैं, बल्कि निजी जानकारियां, विडियो, फोटो शेयर करते हैं। अगर आप किसी का इंपर्सनेशन करते हैं तो आईटी एक्ट 66D में 3 साल की जेल है। अगर आप किसी के बॉडी के प्राइवेट पार्ट की गलत तस्वीर बनाते हैं तो 66E के तहत पांच साल तक की जेल का प्रावधान है। बीते दिनों यूपी के आईपीएस प्रेम प्रकाश का जो विडियो डीपफेक बताकर वायरल हो रहा है। असल में वो डीपफेक नहीं। बल्कि किसी प्रेस कॉन्फ्रेंस के विडियो में उनकी वॉयस को म्यूट कर अलग से ऑडियो मिक्स किया गया है।

प्राइवेसी सेटिंग्स की करें स्टडी

डीसीपी हेमंत तिवारी का कहना है कि डीपफेक हो या मॉर्फ करने के केस। ऐसे अपराध से बचने का आसान उपाय है कि आप सोशल मीडिया में जितने भी अकाउंट पर हैं, उनकी प्राइवेसी सेटिंग्स को स्टडी करें। उसमें आप सुनिश्चित कर लें कि किन किन को आप फोटो, विडियो या कंटेंट दिखाना चाहते हैं। वैसी ही सेटिंग आप करें। आप सावधानी से सोशल मीडिया यूज करें।